iOSの画像認識の活用方法と今後への期待

アクセシビリティ・エンジニア 大塚スマートフォンは私を含めた多くの視覚障害者にとって、日常生活を送るうえで必要不可欠なものとなっています。Webサイトから情報を得たり、SNSなどでコミュニケーションをとるといった目的でももちろん使用するのですが、もう1つ重要な目的があります。それは、目の代わりとして、日常生活を送るうえでの課題を解決するというものです。わかりやすい例としては、OCRや画像認識を利用して、文字や物の色といった本来視覚から得られる情報を補うというものがあります。

スマートフォンのカメラを使った文字や画像の認識そのものは、以前から可能でした。しかし、ここ数年で、Seeing AIやEnvision AIなど、利用できるアプリの選択肢が増えたり、文字や色の認識精度も向上し、比較的精度の高い情報が手軽に得られるようになりつつあります。私自身も、自宅に届いた郵便物の大まかな内容を把握したり、服の色を調べるといったことができるようになるなど、多くの恩恵を受けています。

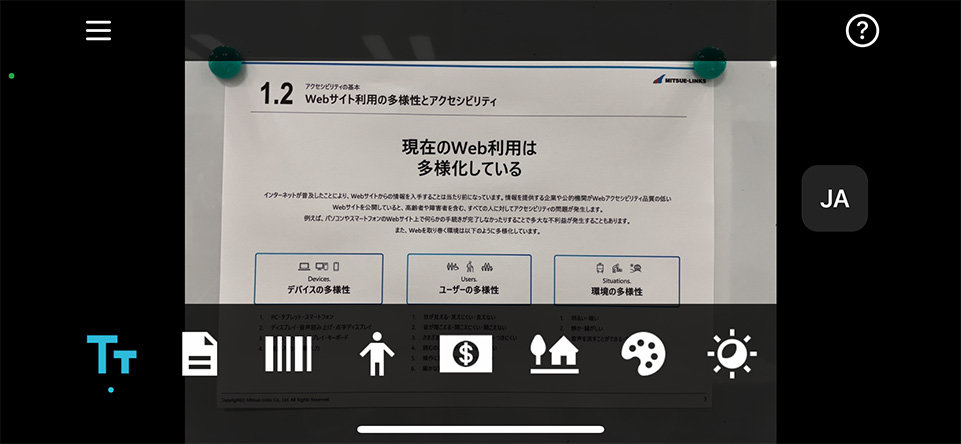

Seeing AIの操作画面

そして最近の話題に目を向けると、音や振動で信号機の状態を伝えるOKOというアプリが開発されたり(日本では早期アクセスへ申し込むことでベータ版が利用できます)、今年の秋リリース予定のiOS16にドアまでの距離を認識するドア検知機能が追加されるなど、今後は屋外での移動中というこれまでとは違った状況でも画像認識を活用できるようになりそうです。

屋外では周囲の状況に気を配りつつカメラを向ける必要があるため、そもそも対象物にカメラを向けづらかったり、短時間しかカメラを向けられないなど屋外特有の様々な課題があることが想像できます。一方、操作方法の工夫や画像認識技術の向上により、ある程度の部分は解消できるのではとも考えています。屋外での画像認識についても、文字や色の認識のように精度が向上し、日常的に利用できるようになってほしいです。そして、より安全に、安心して屋外を歩けるようになることに期待したいです。